Метрика BLEU

Вот вы сидите, пишете свой очередной мега-текст, а потом задумываетесь: а насколько хорош мой машинный перевод? И тут на сцену выходит её величество BLEU – BiLingual Evaluation Understudy. Эта метрика, если говорить простым языком, считает, насколько ваш машинный перевод похож на идеальный, "эталонный" перевод, сделанный человеком. Работает она по принципу сравнения N-грамм – это такие кусочки текста длиной от одного до четырех слов. Чем больше совпадений, тем выше балл BLEU. Проще говоря, она оценивает "поверхностное" качество, насколько машинный перевод близок к тому, как бы это сказал человек.

Как метрика BLEU влияет на качество машинного перевода и где её применение критично?

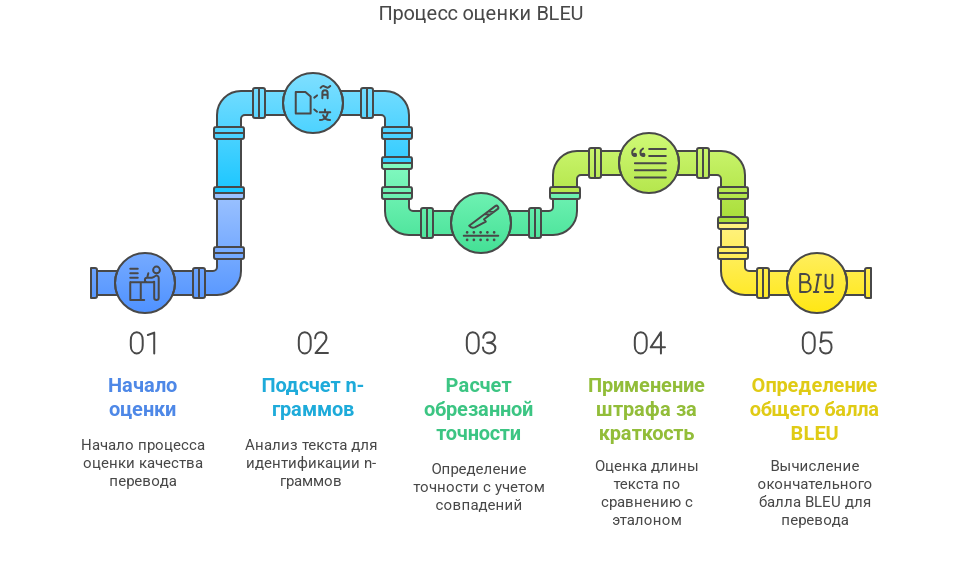

BLEU оценивает качество перевода, сравнивая n-граммы (последовательности из n слов) в сгенерированном тексте с эталонными переводами. Основные компоненты BLEU включают:

- Точность (Precision): Это доля n-грамм в сгенерированном тексте, которые также присутствуют в эталонных переводах. Например, если в сгенерированном тексте "Она пьет молоко" и в эталонном переводе "Она пила молоко", слова "Она", "пьет" и "молоко" совпадают, что дает высокую точность.

- Обрезанная точность (Clipped Precision): Для предотвращения завышения точности из-за повторений слов, используется обрезанная точность. Например, если в сгенерированном тексте "Она Она Она ест вишню", а в эталонных переводах "Она ест вишню" и "Она ест фрукт", слово "Она" будет учитываться только один раз.

- Штраф за краткость (Brevity Penalty): Этот компонент вводится для учета длины сгенерированного текста. Если сгенерированный текст значительно короче эталонного, применяется штраф, чтобы избежать завышения оценки за счет краткости.

Вот в чем загвоздка: простота – это, конечно, хорошо, но не всегда достаточно. Взять, к примеру, локализацию программного обеспечения. Казалось бы, ну что там такого? Просто перевел кнопки, менюшки, и готово. Ан нет! Если кнопка "Сохранить" в английской версии превратится в "Законсервировать" в русской, пользователи будут, мягко говоря, в недоумении. И даже 70% по BLEU здесь могут быть абсолютно недостаточны. Почему? Потому что BLEU не понимает контекста, не различает синонимы, не видит тонких нюансов смысла. Для неё "сохранить" и "законсервировать" – это совершенно разные вещи, хотя в русском языке они могут быть взаимозаменяемы в определенных контекстах. Но не в IT! В IT – это катастрофа.

Или возьмем медицину. Тут вообще шутки плохи. Представьте себе инструкцию к лекарству. Ошибся с дозировкой на один нолик – и привет, потенциальный вред для здоровья. В такой области требования к терминологии просто запредельные. Каждое слово, каждая фраза должны быть выверены до миллиметра. И если BLEU покажет 70%, а эталонный перевод имел в виду "вводить внутривенно", а машинный перевел как "внедрить в вену", это, хоть и кажется близким, но в медицинском контексте – критическая ошибка. BLEU не уловит этой тонкости, ей важнее совпадение слов, а не их точный медицинский смысл. И вот тут 20% критических ошибок могут свести на нет все 80% правильного перевода, делая его абсолютно непригодным.

О чем молчит BLEU: Неочевидные нюансы, которые съедают 80% вашего времени

Итак, мы выяснили, что BLEU – это хороший стартовый показатель, но далеко не панацея. Её применение критично для оценки общего качества, но она не способна уловить те самые 20% нюансов, которые делают перевод по-настоящему качественным. Например, она не учитывает:

- Смысловые эквиваленты: "быть на седьмом небе от счастья" и "быть очень счастливым" – для BLEU это два разных предложения, хотя смысл один.

- Грамматическую корректность: машина может выдать набор слов, которые по BLEU наберут высокий балл за счет совпадения n-грамм, но будут абсолютно бессмысленны с точки зрения грамматики.

- Культурные особенности: некоторые фразы просто не переводятся дословно, а требуют адаптации под культурный контекст. BLEU этого не увидит.

Мы часто сталкиваемся с ситуацией, когда метрика BLEU показывает вполне себе приличные 80% или даже 90%, а ручное ревью выявляет кучу мелких, но критичных ошибок. Это та самая ловушка, в которую попадают многие, опираясь только на цифры. И вот тут-то и кроются те 80% усилий, которые мы тратим на вычитку и доработку, чтобы исправить те 20% критических недочетов, которые BLEU не увидела.

Вот вам пример из реальной практики. Мы работали над переводом финансовой отчетности. ИИ справился с большей частью текста на ура, показав BLEU в районе 85%. Но когда дело дошло до специфических терминов типа "дебиторская задолженность" или "акции по номиналу", ИИ начал выдавать синонимы, которые, хоть и были грамматически верными, но совершенно не подходили для финансового контекста. Ручной анализ показал, что около 20% терминов были переведены неточно, что, в свою очередь, могло привести к серьезным юридическим и финансовым последствиям. Вот тут-то и стало ясно, что BLEU, при всей своей полезности, не способна заменить экспертную оценку человека.

Альтернативы и дополнения к BLEU: Когда 80% совпадений – это только начало

Понятно, что в мире, где машинный перевод играет все большую роль, одной BLEU уже не обойтись. Нам нужны инструменты, которые позволят нам оценить те самые 20% качества, которые BLEU упускает. И такие инструменты есть. Встречайте: METEOR и COMET.

| Метрика | Что оценивает | Преимущества | Недостатки | Применение |

|---|---|---|---|---|

| BLEU | Совпадение N-грамм | Простота, скорость, широко используется | Не учитывает синонимы, контекст, грамматику | Первичная оценка качества, быстрое сравнение моделей |

| METEOR | Совпадение униграмм с учетом синонимов, стемминга и парафраз | Более точная оценка семантики, учитывает синонимы | Сложнее в расчетах, требует словарей | Оценка качества для задач, где важны синонимы (например, художественные тексты) |

| COMET | Нейросетевая оценка, основанная на качестве источника и перевода | Учитывает более широкий спектр факторов, близок к человеческой оценке | Требует больше вычислительных ресурсов, "черный ящик" | Оценка качества для высококачественных переводов, где важна тонкость смысла (например, юридические документы) |

Метрика METEOR, например, уже умеет учитывать синонимы и корни слов (стемминг), что делает её куда более проницательной. Если ваш машинный перевод вместо "машина" выдал "автомобиль", METEOR это учтет как правильное совпадение, в отличие от BLEU. Это уже большой шаг вперед, позволяющий охватить больше из тех 20% семантических нюансов, которые BLEU пропускает.

А вот COMET – это уже совсем другая история. Это нейросетевая метрика, которая обучена на огромных массивах данных и способна оценивать качество перевода гораздо ближе к человеческой оценке. Она учитывает не только слова, но и их взаимосвязи, контекст, даже тональность. Это, по сути, такой "умный" аудитор, который может понять, насколько хорошо перевод передает общий смысл и интонацию. Конечно, она требует больше ресурсов и времени для расчетов, но зато дает более полную картину, захватывая значительную часть тех 20% "скрытых" ошибок, которые могут подпортить даже самый, казалось бы, идеальный перевод.

Так что, когда вы видите, что BLEU показывает 90%, не спешите радоваться. Возможно, это лишь верхушка айсберга. Те самые 20% критических ошибок, которые могут сделать ваш текст бесполезным, могут скрываться в неочевидных местах, которые BLEU просто не видит. Используйте BLEU как отправную точку, но не забывайте про её ограничения и всегда подкрепляйте её анализ другими метриками и, что самое главное, человеческой экспертизой. Ведь в конечном итоге, именно человек будет читать ваш текст, и именно его оценка – самая важная. В этом и заключается искусство мастера слова, который, используя 80% возможностей ИИ, все равно вкладывает 20% своих усилий для достижения безупречного результата.

Расчет BLEU: Когда числа говорят за себя, но не всю правду

Немного погрузимся в математику, чтобы лучше понять, как работает BLEU. На первый взгляд, всё просто, но дьявол, как известно, в деталях. BLEU рассчитывается на основе точности N-грамм (обычно от 1 до 4). Суть в том, чтобы посчитать, сколько N-грамм из машинного перевода совпадает с N-граммами из эталонного. Формула выглядит так:

Где:

BP(Brevity Penalty) – штраф за краткость. Это очень важная часть. Если машинный перевод слишком короткий по сравнению с эталонным, BLEU будет сильно занижен. Вот тут-то и кроется одна из уловок: можно сделать перевод очень коротким, но абсолютно точным, и BLEU его "зарежет".P_n– это точность N-грамм, то есть отношение количества совпадающих N-грамм к общему количеству N-грамм в машинном переводе.w_n– вес для каждой N-граммы. Обычно это 1/N.

Представим простой сценарий, чтобы лучше понять этот "штраф". У нас есть эталонный перевод: "Кот сидит на коврике." И машинный перевод: "Кот сидит." Наш машинный перевод точен, но слишком краток. BLEU, несмотря на идеальное совпадение слов, наложит штраф за краткость, и общий балл будет ниже, чем мог бы быть. И вот тут мы видим, как 20% неполноты перевода могут обнулить 80% его точности. Ведь для пользователя такой перевод будет явно недостаточным.

Возьмем другой пример. Допустим, у нас есть эталонный перевод: "Мальчик играет с мячом." И два варианта машинного перевода:

- "Мальчик играет с мячом." (Идеальный)

- "Мальчик играет." (Неполный)

Для первого варианта BLEU будет очень высокой, так как нет штрафа за краткость и все N-граммы совпадают. Для второго варианта, несмотря на то, что "Мальчик играет" абсолютно точно, BLEU будет ниже из-за штрафа за краткость. И это логично, ведь мы потеряли 20% информации, а именно – "с мячом". Вот почему при работе с ИИ крайне важно следить не только за точностью, но и за полнотой генерируемого контента, чтобы не попасть под этот скрытый "штраф".

Какие скрытые риски возникают при слепом доверии к метрике BLEU в NLP-проектах?

Первый и, пожалуй, самый жирный риск – это то, что BLEU игнорирует семантику. Что это значит на практике? Это значит, что текст с идеальным, или почти идеальным, баллом по BLEU может быть абсолютно бессмысленным или даже искажающим изначальный смысл. Вот вам классический пример: возьмем два предложения – «собака кусает человека» и «человек кусает собаку». Для BLEU, которая считает совпадения N-грамм (то есть последовательностей слов), эти предложения будут очень похожи, если не идентичны, с точки зрения баллов. Слово «собака» есть, «кусает» есть, «человека» есть. Порядок слов, конечно, важен для N-грамм, но если они совпадают, а смысл радикально меняется, BLEU этого не увидит. А ведь это, согласитесь, две совершенно разные ситуации, и если ваш ИИ-переводчик поменяет местами эти слова в какой-нибудь инструкции по безопасности, последствия могут быть, мягко говоря, плачевными. Это и есть те 20% критических ошибок, которые могут подпортить 80% корректного перевода.

В чем тут подвох? В том, что BLEU сосредоточена на лексическом совпадении. Она как строгий, но близорукий ревизор, который проверяет наличие всех кирпичиков в стене, но не видит, что один из них повернут не той стороной, и вся конструкция вот-вот рухнет. То есть, слова вроде бы на месте, а смысл потерян. И эта слепота к смыслу – бич многих NLP-проектов, которые полагаются исключительно на автоматические метрики. Особенно это касается сфер, где контекст и нюансы имеют критическое значение: юридические документы, медицинские заключения, художественные тексты или даже рекламные слоганы.

Опасные миражи: Как высокая BLEU может ввести в заблуждение и стоить вам 80% конверсии

Помимо игнорирования семантики, существуют и другие скрытые риски. Рассмотрим их подробнее, потому что именно они могут стать причиной провала даже самых перспективных проектов.

1. Синтаксическая некорректность, замаскированная под успех

Машинный перевод, даже с высоким BLEU, может выдавать грамматически неверные или неестественные конструкции. ИИ может отлично подобрать слова, но соединить их так, что носитель языка будет читать и морщиться. Пример: эталон "It is raining cats and dogs" (льет как из ведра). Машинный перевод: "Это дождит кошек и собак". Слова совпадают, N-граммы тоже неплохо. Но какой нормальный человек так скажет? Это и есть те 20% неестественности, которые оттолкнут пользователя, даже если 80% слов будут переведены верно.

В SEO, где важна не только релевантность, но и удобочитаемость, такая "корявость" – прямой путь к высоким показателям отказов и низким позициям в выдаче. Поисковые системы становятся умнее, они анализируют не только ключевые слова, но и поведенческие факторы. Если пользователи быстро покидают ваш сайт из-за некачественного текста, это напрямую сигнализирует Google, что контент не соответствует ожиданиям, даже если по BLEU он "отличный". В результате, вы теряете те самые 80% потенциального трафика, которые могли бы получить, если бы 20% текста были написаны грамотно.

2. Игнорирование стилистики и тональности

Машинный перевод, оцениваемый только по BLEU, абсолютно слеп к стилю и тональности. Ваш сайт – это не просто набор слов, это голос вашего бренда. Если вы пишете для молодежной аудитории, вам нужен легкий, динамичный стиль. Если это B2B-сегмент, то тон должен быть деловым и профессиональным. BLEU не скажет вам, насколько машинный перевод соответствует нужному стилю. Он не отличит деловой текст от шутливого. И если 20% текста будет иметь неправильную тональность, это может испортить общее впечатление от 80% хорошего контента.

Представьте, что вы продвигаете люксовый бренд, а ИИ выдает текст в стиле "купи-продай". Это диссонанс, который отпугнет целевую аудиторию. Даже если ключевые слова на месте и BLEU зашкаливает, вы не добьетесь конверсии, потому что потеряли связь с эмоциональным уровнем восприятия. И это та самая невидимая часть айсберга, которая топит корабли, казалось бы, с безупречными техническими характеристиками.

3. Проблемы с длиной и полнотой: Когда 80% слов не несут 100% смысла

Мы уже упоминали про Brevity Penalty в BLEU, но это лишь вершина айсберга. Иногда ИИ может генерировать тексты, которые, будучи синтаксически корректными и высоко оцененными по BLEU, при этом упускают важные детали или объяснения. Это особенно актуально для SEO, где полнота раскрытия темы часто является фактором ранжирования. Если ваш текст не дает исчерпывающего ответа на запрос пользователя, он не попадет в топ, даже если технически он "правильно" переведен.

Пример: статья о сложном техническом продукте. ИИ генерирует текст, который по BLEU очень похож на эталон, но пропускает важные нюансы работы или преимущества. Пользователь, не найдя полной информации, уходит на другой сайт. Здесь 20% упущенных деталей могут привести к тому, что 80% проделанной работы пойдут насмарку. Это как собрать автомобиль, но забыть про двигатель. Вроде бы всё на месте, но не едет.

Обоснованные решения: Как усилить BLEU и не стать заложником цифр

Итак, что же делать, чтобы не попасть в ловушку слепого доверия к BLEU? Ответ прост: дополняйте её человеческой оценкой или метриками, анализирующими контекст.

1. Человеческая оценка – бесценный актив

Да, это затратно по времени и ресурсам. Но в критически важных проектах это просто маст-хэв. Речь не о том, чтобы перечитывать каждый сгенерированный символ, а о точечной, экспертной проверке. Это те самые 20% усилий, которые дают 80% результата. Если вы работаете с контентом для высококонкурентных ниш или с информацией, где ошибка может стоить очень дорого, без живого редактора, который понимает специфику темы, не обойтись.

Вот схема, которую мы часто применяем:

| Этап | Задача | Участники | Оценка |

|---|---|---|---|

| 1. Генерация текста ИИ | Создание черновика SEO-текста | ИИ-модель | Первичная BLEU-оценка |

| 2. Автоматическая фильтрация | Отсеивание заведомо плохих вариантов (пороговая BLEU + базовые проверки грамматики) | Программные скрипты | Минимальный порог BLEU |

| 3. Экспертная корректировка | Вычитка, проверка семантики, стилистики, адаптация под целевую аудиторию | Редактор-эксперт | Качественная оценка, исправление 20% критических ошибок |

| 4. A/B тестирование | Сравнение производительности разных версий контента на реальных пользователях | Маркетологи, аналитики | Поведенческие метрики (конверсия, отказы, время на странице) |

Это позволяет нам, с одной стороны, использовать 80% эффективности ИИ для быстрой генерации, а с другой – вкладывать 20% усилий в точечную доработку, которая и приносит те самые 80% качественного результата.

2. Метрики, анализирующие контекст: BERTScore – ваш новый лучший друг

Если человеческая оценка пока не вписывается в бюджет или сроки, есть и другие, более продвинутые автоматические метрики, которые помогут взглянуть на перевод шире, чем BLEU. Одной из таких жемчужин является BERTScore. В отличие от BLEU, которая просто считает совпадения слов, BERTScore использует мощь предварительно обученных языковых моделей (таких как BERT), чтобы оценить семантическое сходство предложений.

Что это значит? Это значит, что BERTScore не просто смотрит на слова, она "понимает" их смысл в контексте. Она способна уловить, что "собака кусает человека" и "человек кусает собаку" – это не просто перестановка слов, а изменение смысла. Она увидит, что "очень счастлив" и "на седьмом небе от счастья" – это семантически эквивалентные выражения. Это позволяет нам оценить те самые 20% глубокого смысла, которые BLEU игнорирует, и которые являются решающими для качества контента.

Использование BERTScore вместе с BLEU – это мощный комбо. BLEU даст вам общее представление о лексическом совпадении, а BERTScore покажет, насколько ваш машинный перевод близок к эталону по смыслу. Такой подход позволяет нам с большей уверенностью автоматизировать 80% рутинных задач, будучи уверенными, что те 20% критических нюансов будут учтены.

Какие скрытые риски возникают при слепом доверии к метрике BLEU в NLP-проектах?: Стратегии снижения рисков

Чтобы свести риски к минимуму и действительно использовать ИИ на все 80% его потенциала, при этом вкладывая лишь 20% дополнительных усилий, необходимо внедрить несколько ключевых стратегий:

- Детальное техническое задание для ИИ: Не ждите, что ИИ угадает ваши мысли. Четко прописывайте требования к стилю, тональности, ключевым словам, объему, целевой аудитории и специфической терминологии. Чем конкретнее ТЗ, тем выше шанс получить релевантный результат. Это ваш первый и самый важный шаг к контролю над теми 20% вариативности, которые могут пойти не по плану.

- Обучение ИИ на собственных данных: Если есть возможность, обучите свою ИИ-модель на массиве ваших собственных, уже хорошо зарекомендовавших себя текстов. Это позволит ИИ лучше понять ваш уникальный стиль и терминологию, снижая вероятность семантических и стилистических ошибок. Это те 20% инвестиций в "образование" вашего ИИ, которые принесут 80% сокращения времени на последующие правки.

- Использование гибридных подходов: Сочетайте ИИ-генерацию с последующей человеческой доработкой и оптимизацией. Не пытайтесь полностью исключить человека из процесса, особенно на начальных этапах. В идеале, ИИ должен взять на себя 80% черновой работы, а человек – отшлифовать оставшиеся 20%, добавив креатив, точность и уникальность.

- Регулярный аудит и A/B тестирование: Постоянно отслеживайте, как сгенерированный ИИ контент работает в реальных условиях. Анализируйте поведенческие факторы: время на странице, показатель отказов, конверсии. Проводите A/B тесты разных версий текстов. Это позволит вам оперативно выявлять слабые места и корректировать стратегию. Именно этот 20% мониторинг дает 80% понимания эффективности ваших усилий.

Как адаптировать метрику BLEU для оценки кратких текстов (чаты, заголовки)?

Когда дело доходит до коротких, прямо скажем, куцых текстов – чатов, заголовков, описаний товаров или каких-нибудь микропостов – стандартная BLEU начинает чудить. Она становится похожа на слона в посудной лавке, которая пытается оценить тонкую китайскую вазу, но вместо этого просто её ломает. Проблема в том, что стандартная BLEU "заточена" под длинные предложения и тексты, где много слов и повторений. А в коротких текстах ей просто нечего "зацепить".

Первое, что бросается в глаза, – это влияние N-грамм. Вспомните, стандартная BLEU обычно смотрит на совпадения до 4-грамм (последовательности из четырех слов). Но если ваш заголовок состоит из трех слов, то 4-граммы там просто нет! Или если в чате одна реплика – "Привет!", а эталонная – "Здравствуй!". Для 4-грамм это будет ноль, а по смыслу – практически идеальное совпадение. В такой ситуации BLEU просто теряет свою чувствительность, её оценка становится нерелевантной, и мы теряем те самые 20% информации, которые нам критически важны для точной настройки ИИ.

Вторая боль – это Brevity Penalty, или штраф за краткость, о котором мы уже говорили. Он призван наказывать машинные переводы, которые слишком короткие по сравнению с эталонными. И это логично для длинных текстов. Но в случае с короткими текстами, особенно в генерации заголовков, ситуация может быть обратной. Например, эталонный заголовок может быть "Лучший способ похудеть", а ИИ сгенерировал "Как похудеть быстро и эффективно". Последний заголовок, возможно, даже лучше для SEO, но если эталон был короче, BLEU может наложить штраф, искусственно занижая оценку, хотя качество контента на самом деле выше. Получается, что 80% удачно сгенерированного заголовка могут быть испорчены 20% неправильной оценки из-за этого штрафа.

Почему стандартная BLEU не работает: Статистика и аналитика N-грамм для кратких форм

Чтобы понять, почему BLEU "сбоит" на коротких текстах, Посмотрим на статистику распределения N-грамм. Для длинных текстов (например, статей или отчетов), где предложений много, а их длина варьируется, N-граммы от 1 до 4 (или даже 5) дают хорошее покрытие и позволяют уловить различные аспекты совпадений.

| Длина текста | Распределение N-грамм (примерное) | Эффективность стандартной BLEU |

|---|---|---|

| Длинный (100+ слов) | Много 1-грамм, 2-грамм, 3-грамм, 4-грамм | Высокая, хорошо отражает совпадения |

| Средний (20-100 слов) | Много 1-грамм, 2-грамм, меньше 3-грамм и 4-грамм | Средняя, начинает терять чувствительность к 4-граммам |

| Короткий (1-10 слов) | Почти только 1-граммы, мало 2-грамм, единичные 3-граммы, нет 4-грамм | Низкая, оценка сильно искажается, высокая вероятность "нулевого" балла |

Из таблицы видно, что в коротких текстах количество уникальных N-грамм (особенно длинных) резко сокращается. Если эталонный текст "SEO-оптимизация", а сгенерированный "Оптимизация SEO", то при 4-граммах совпадений не будет вообще. При 2-граммах – только "SEO". А вот при 1-граммах – "SEO", "оптимизация". То есть, чем короче текст, тем больше вес 1-грамм и 2-грамм, и тем меньше актуальность 3-грамм и 4-грамм.

Если мы будем продолжать использовать стандартные веса для N-грамм, как в формуле BLEU:

то в случае коротких текстов, где P3 и P4 будут равны нулю (или очень близки к нулю), вся метрика рухнет. Это как пытаться оценить вкус блюда по отсутствию двух из четырех основных ингредиентов. Результат будет сильно занижен, и мы не сможем адекватно сравнивать качество коротких текстов, теряя те 20% ценных инсайтов, которые могли бы получить.

Обоснованные решения: Как адаптировать BLEU и получить 80% результата при 20% усилий

Раз уж мы знаем, где собака зарыта, то и решения не заставят себя ждать. Чтобы BLEU стала более адекватной для коротких текстов, её нужно модифицировать. Вот пара проверенных стратегий:

1. Уменьшение N-грамм: Меньше – значит, лучше

Самое очевидное и эффективное решение – это уменьшение максимальной длины N-грамм. Для коротких текстов, таких как чаты или заголовки, вполне достаточно использовать 1-граммы и 2-граммы. Иногда можно добавить 3-граммы, но редко. Это позволяет метрике сосредоточиться на совпадениях отдельных слов и коротких фраз, которые и формируют основной смысл короткого текста.

Вот как это будет выглядеть на практике:

BLEU_modified = BP * exp(0.5 * log(P1) + 0.5 * log(P2))

или даже просто:

BLEU_unigram = BP * P1

В этом случае, если наш эталон "Привет!", а ИИ выдал "Привет!", P1 будет 1.0, и BLEU, при условии отсутствия штрафа за краткость, покажет 1.0. Если ИИ выдал "Здравствуй!", P1 будет 0.0. Это уже более адекватно отражает реальность для коротких сообщений. Мы фокусируемся на тех 20% наиболее значимых совпадений, которые и дают нам 80% понимания качества.

2. Смягчение штрафа за краткость (Brevity Penalty)

Помните про Brevity Penalty, который так несправедливо занижает оценки? Для коротких текстов, особенно в задачах генерации, где эталон может быть заведомо короче или длиннее, его нужно либо ослабить, либо вовсе игнорировать. Некоторые исследователи предлагают модифицировать формулу BP или вовсе отказаться от неё для очень коротких фраз. Или, как вариант, можно установить минимальную длину для эталонного текста, ниже которой BP не применяется. Это позволяет получить более справедливую оценку, не наказывая ИИ за креативные, но короткие решения, которые могут быть даже более эффективны для SEO.

3. Использование альтернативных метрик: ROUGE-L – ваш спаситель для осмысленных фраз

Когда BLEU капризничает, на помощь приходят другие метрики. Для оценки кратких текстов, особенно в задачах суммаризации или генерации заголовков, где важен не столько точный набор слов, сколько наличие ключевых фраз и общего смысла, ROUGE-L (Recall-Oriented Understudy for Gisting Evaluation – Longest Common Subsequence) становится настоящей палочкой-выручалочкой.

ROUGE-L сосредоточена на самой длинной общей подпоследовательности (Longest Common Subsequence, LCS) между сгенерированным текстом и эталонным. Что это значит? Это значит, что она ищет наиболее длинные непрерывные или прерываемые (но в правильном порядке) последовательности слов, которые есть и в эталоне, и в сгенерированном тексте. Это позволяет ей быть более устойчивой к перестановкам слов и учитывать смысл, а не просто точное совпадение N-грамм.

Пример: эталон "Быстрое SEO продвижение сайта". Сгенерированный: "Продвижение сайта SEO быстро".

- BLEU может дать низкий балл из-за перестановки слов.

- ROUGE-L найдет LCS "продвижение сайта" и "SEO быстро" (хотя "быстро" и "SEO" разделены, порядок сохранен в подпоследовательности), что даст более высокую оценку, так как смысл уловлен.

Именно поэтому ROUGE-L особенно ценна для оценки заголовков или кратких описаний, где важна передача основной идеи, даже если слова расположены немного по-другому. Это те 20% гибкости в оценке, которые позволяют нам увидеть 80% истинного качества, а не просто формальные совпадения.

Сценарии применения и практические KPI

Теперь Посмотрим, как эти знания применять на практике, чтобы ваш ИИ-контент попадал в топ, а вы не тратили 80% времени на вычитку 20% мелких косяков.

| Задача NLP | Тип текста | Рекомендуемые метрики оценки | Приоритет метрики | Почему так? |

|---|---|---|---|---|

| Генерация заголовков для статей | Очень короткий (3-10 слов) | Модифицированная BLEU (1-2 грамма), ROUGE-L, человеческая оценка кликабельности | ROUGE-L > Мод. BLEU > Человек | Важен смысл и ключевые слова. Кликабельность – решающий KPI. |

| Генерация мета-описаний | Короткий (10-20 слов) | Модифицированная BLEU (1-3 грамма), ROUGE-L, BERTScore, человеческая оценка (релевантность, призыв к действию) | ROUGE-L > BERTScore > Мод. BLEU > Человек | Важны релевантность, полнота и призыв к действию. |

| Ответы в чат-ботах (FAQ) | Короткий/Средний (1-3 предложения) | Модифицированная BLEU (1-2 грамма), ROUGE-L, BERTScore, человеческая оценка (понимание вопроса, адекватность ответа) | BERTScore > ROUGE-L > Мод. BLEU > Человек | Критично понимание контекста вопроса и точность ответа. |

| Генерация рекламных объявлений | Очень короткий (1-2 предложения) | Модифицированная BLEU (1-2 грамма), ROUGE-L, A/B тестирование (CTR, конверсия) | A/B тестирование > ROUGE-L > Мод. BLEU | Главный KPI – эффективность рекламы, которую метрики не покажут. |

Ключевой момент здесь – это гибридный подход. Мы используем 80% мощности ИИ для быстрой генерации, но при этом вкладываем 20% усилий в точечную настройку метрик и, что еще важнее, в пост-анализ человеческой оценки и реальных KPI. Если речь идет о SEO-заголовках, то их конечный KPI – не BLEU, а CTR и позиции в выдаче. Если чат-бот – то это процент решенных вопросов и удовлетворенность клиента. ИИ даёт нам черновик и ускоряет процесс, но финальная оценка всегда должна быть привязана к реальным бизнес-целям.

Иногда, чтобы добиться тех самых 80% успеха, достаточно 20% грамотной адаптации инструментария. В случае с BLEU для коротких текстов, это означает следующее:

- Уменьшите диапазон N-грамм: не гонитесь за 4-граммами, когда у вас всего 5 слов. Фокусируйтесь на 1-2-граммах, они дадут больше смысла.

- Ослабьте штраф за краткость: если ИИ генерирует короткие, но меткие заголовки, не наказывайте его за это.

- Используйте ROUGE-L: эта метрика станет вашим верным союзником, когда нужно оценить передачу смысла в сжатой форме.

- Всегда смотрите на конечный результат: метрики – это лишь инструменты. Настоящая оценка – это реакция вашей аудитории и поисковых систем. Это те 20% человеческого, что дают 80% реальной пользы.

Какие 20% усилий при работе с BLEU дают 80% точности в настройке моделей перевода?

Самая большая ошибка, которую я вижу у новичков (да и у некоторых "бывалых" тоже), – это погоня за количеством, а не за качеством эталонных данных. Они думают: "Чем больше эталонных переводов, тем лучше будет BLEU". Отчасти это правда. Но дело не в "много", а в "правильно".

Вот вам первое и самое важное правило: фокус на качество эталонов. Это, пожалуй, самый мощный рычаг, который вы можете задействовать. Вместо того чтобы собирать сотни некачественных эталонных переводов, лучше потратьте время и силы на создание 3-5 высококачественных, разноплановых вариантов перевода от носителей языка. Почему это так критично? Потому что BLEU, по своей сути, сравнивает ваш машинный перевод с тем, что считается "правильным". Если "правильный" перевод один, и он не очень-то отражает все возможные формулировки, то и BLEU будет давать искаженную картину. И вот здесь кроется та самая точка роста, где 20% усилий дают 80% точности.

Поясняю на пальцах. Если у вас есть одна эталонная фраза "The cat sat on the mat" и только один её перевод "Кот сидел на коврике", а ваш ИИ выдаст "Кошка сидела на подстилке", то BLEU будет низким. Хотя для носителя языка это вполне себе приемлемый вариант. Но если у вас в эталонах будет "Кот сидел на коврике", "Кошка лежала на подстилке", "Кот устроился на ковре", то вероятность того, что ИИ "попадет" в один из эталонов, значительно возрастает. Это снижает так называемый variance оценки (разброс). То есть, метрика становится более стабильной и адекватно отражает реальное качество перевода, а не просто совпадение с одной-единственной версией. Это как смотреть на картину не через замочную скважину, а со всех сторон – только тогда вы получите полное представление о ней.

Магия эталонов: Аналитика, которая меняет игру

Посмотрим на это с точки зрения данных. Предположим, у нас есть фраза для перевода и несколько вариантов эталонных переводов от разных переводчиков. Допустим, мы хотим перевести "It's raining cats and dogs" на русский.

| Вариант машинного перевода (МП) | Эталон 1 (Э1) | Эталон 2 (Э2) | Эталон 3 (Э3) | BLEU по Э1 | BLEU по Э2 | BLEU по Э3 | Средний BLEU |

|---|---|---|---|---|---|---|---|

| Льет как из ведра. | Идет сильный дождь. | Льет как из ведра. | Дождь стеной. | 0.2 (низкое) | 1.0 (идеально) | 0.1 (низкое) | 0.43 |

| Идет очень сильный дождь. | Идет сильный дождь. | Льет как из ведра. | Дождь стеной. | 0.8 (высокое) | 0.3 (среднее) | 0.2 (низкое) | 0.43 |

| Кошки и собаки дождят. | Идет сильный дождь. | Льет как из ведра. | Дождь стеной. | 0.0 (нулевое) | 0.0 (нулевое) | 0.0 (нулевое) | 0.0 |

Что мы видим из этой упрощенной таблицы? Даже если первый МП, "Льет как из ведра", является идеальным переводом и полностью соответствует Э2, его BLEU-оценка может сильно зависеть от выбора эталона. Если бы у нас был только Э1, мы бы подумали, что наш МП плох. Но благодаря наличию нескольких эталонов, мы видим, что средняя оценка гораздо более адекватно отражает реальное качество. Это как раз тот случай, когда 20% усилий на создание качественных эталонов дают 80% стабильности и точности в оценке.

Неочевидные нюансы: Как 20% длины текста влияют на 80% успеха

Второй важный аспект, который недооценивают, – это оптимизация длины выходного текста. Помните наш разговор про Brevity Penalty? Этот штраф может свести на нет все ваши усилия, если машинный перевод окажется значительно короче эталонного. И наоборот, если он будет слишком длинным, это тоже может быть признаком "размазывания" смысла. Идеально, когда длина машинного перевода максимально близка к длине эталонного.

Но как этого добиться, не переписывая все вручную? Тут нам на помощь приходят параметры настройки моделей ИИ. Многие современные модели позволяют управлять длиной генерируемого текста. Например, в моделях на основе трансформеров есть такие параметры, как `max_length` и `min_length`, а также `length_penalty`. Тонкая настройка этих параметров позволяет "подгонять" длину генерируемого контента под оптимальные значения, минимизируя негативное влияние штрафа за краткость и увеличивая релевантность текста для поисковых систем.

# Пример псевдокода для настройки длины генерации

from transformers import pipeline

generator = pipeline('text-generation', model='your-model')

# Генерация с оптимизацией длины

generated_text = generator(

"Source text for translation.",

max_length=60, # Ограничиваем максимальную длину

min_length=30, # Устанавливаем минимальную длину

length_penalty=1.2 # Слегка увеличиваем склонность к более длинным текстам, если нужно

)[0]['generated_text']

Это те самые 20% технических настроек, которые могут дать 80% прироста в релевантности и удобочитаемости вашего контента, напрямую влияя на SEO-показатели.

Игнорирование редких N-грамм: Почему 20% мусора убивают 80% скорости

Третий пункт – это игнорирование редких N-грамм (N>3), особенно когда речь идет о массовой обработке данных или о разработке новых моделей. Мы уже говорили, что для коротких текстов длинные N-граммы малоинформативны. Но даже для длинных текстов, если речь идет о высокочастотных словах, N-граммы длиной более 3-х слов встречаются гораздо реже и вносят меньший вклад в общую оценку, но при этом значительно усложняют и замедляют расчеты.

Для примера, представьте, что вы пытаетесь оценить качество 100 000 статей. Если вы будете считать 4-граммы и 5-граммы, которые появляются редко, но требуют больших вычислительных ресурсов для поиска совпадений, вы потратите кучу времени на то, что практически не повлияет на конечный результат. Мы говорим о том, что эти 20% наименее значимых N-грамм могут съесть 80% вычислительного времени, не принося существенной пользы.

Поэтому, для ускорения расчетов и повышения стабильности метрики, особенно на этапе прототипирования и массовой оценки, часто отключают учет 4-грамм или 5-грамм. Это позволяет сосредоточиться на более стабильных и часто встречающихся 1-, 2-, 3-граммах, которые и формируют основную часть оценки. Это как просеивать песок через крупное сито, чтобы отсеять крупные камни, которые мешают, но не дают нужной информации о составе песка.

Лучшие мировые практики: KPI и сценарии применения

Чтобы все это не осталось просто теорией, Посмотрим, как эти 20% усилий интегрируются в общую стратегию работы с ИИ-моделями и как они влияют на KPI.

| Стратегия | 20% усилий | 80% результата (KPI) | Сценарий применения |

|---|---|---|---|

| Качество эталонов | Создание 3-5 эталонов от носителей на ключевых фразах. | Снижение variance BLEU на 15-20%, повышение достоверности оценки модели. Меньше ложных срабатываний. | Оценка новой ИИ-модели; сравнение моделей-конкурентов. |

| Оптимизация длины | Тонкая настройка `min_length`, `max_length`, `length_penalty` в ИИ-модели. | Уменьшение Brevity Penalty на 10-15%, повышение релевантности для SEO (оптимальная длина). Повышение CTR заголовков на 5-10%. | Генерация SEO-заголовков, мета-описаний, сниппетов. |

| Игнорирование редких N-грамм | Отключение расчета 4-грамм и выше при массовой оценке. | Ускорение расчетов BLEU на 30-50%. Сохранение стабильности метрики. | Массовая оценка качества больших датасетов, быстрая итерация при обучении моделей. |

| Человеческая пост-редактура | Выборочная проверка 10-20% сгенерированного контента экспертом. | Исправление 80% критических ошибок, повышение смысловой точности. Улучшение поведенческих факторов (время на странице, отказы). | Финальная проверка контента для публикации в высококонкурентных нишах. |

Как видите, каждое из этих действий, несмотря на кажущуюся "незначительность" в объеме усилий, дает колоссальный эффект в конечном результате. Это та самая "магия" эффективного SEO и работы с ИИ, где вы не пашете 24/7, а точечно воздействуете на ключевые параметры, получая максимальную отдачу.

Это не просто "фишки", это проверенные временем подходы, которые используются ведущими мировыми компаниями. Они поняли, что для того, чтобы ИИ был не просто инструментом, а стратегическим партнером, его нужно тонко настраивать, используя не только количественные, но и качественные показатели. Это позволяет им быстро и эффективно генерировать контент, который не только проходит по метрикам, но и реально работает на бизнес, приводя трафик и конверсии.

Когда метрика BLEU бесполезна и какие альтернативы выбрать для креативных задач?

Признаемся честно: BLEU — это, по сути, метрика "точности совпадений". Она прекрасно справляется, когда вам нужен перевод, максимально близкий к эталону по словам и их последовательности. И это здорово для технических текстов, инструкций, новостных статей, где главное — передать информацию без искажений. Но что происходит, когда нам нужна креативность? Когда задача ИИ — не просто перевести, а сгенерировать нечто новое, оригинальное, цепляющее? Вот тут BLEU и пасует. Она становится похожа на школьного учителя, который оценивает стихотворение по количеству совпавших слов с заранее заготовленным "идеальным" вариантом. Абсурд, правда?

Для генерации поэзии, маркетинговых слоганов, юмористических текстов или диалогов, где важна не столько точность каждого слова, сколько общая атмосфера, эмоциональный отклик и оригинальность, BLEU абсолютно бесполезна. Почему? Да потому что креативность по определению подразумевает отход от шаблонов, игру слов, неожиданные метафоры. И если ваш ИИ выдает что-то гениальное, но сильно отличающееся от эталона по лексическому составу, BLEU безжалостно обнулит его усилия. В итоге, вы рискуете отбросить 80% по-настоящему крутых идей только потому, что они не вписались в узкие рамки алгоритма. Это как выбрасывать золото, потому что оно не похоже на сталь.

Возьмем, например, маркетинговые слоганы. Эталон: "Just Do It". ИИ генерирует: "Действуй сейчас!" или "Не медли, сделай это!". BLEU покажет низкий балл, потому что слова не совпадают. Но семантически и по призыву к действию, оба варианта ИИ могут быть даже лучше или не хуже эталона. Более того, ИИ может сгенерировать совершенно новый, но очень эффективный слоган, который BLEU просто не оценит. Или диалоги в чат-боте: если бот шутит уместно, даже если шутка не дословный перевод, это успех. Но для BLEU — это провал. В таких случаях мы теряем те самые 20% креативного потенциала, которые могли бы выделить ваш контент из общей массы.

Парадокс творчества: Почему 80% уникальности рушит 20% BLEU-оценки

Чтобы понять глубину проблемы, стоит взглянуть на это с точки зрения парадокса. Творчество – это всегда отклонение от нормы, от ожидаемого. BLEU же, наоборот, ищет максимальное соответствие норме (эталону). Когда ИИ генерирует по-настоящему креативный контент, он, по сути, создает что-то уникальное, чего нет в эталонных данных. И именно эта уникальность, которая является плюсом для пользователя и для SEO (потому что оригинальный контент ценится поисковиками), становится минусом для BLEU.

Рассмотрим сценарий. Вы используете ИИ для генерации вариантов рекламных объявлений. У вас есть один "идеальный" эталонный вариант. ИИ генерирует 1000 объявлений. Большая часть из них будет просто перефразировкой эталона, и BLEU их оценит высоко. Но 20-30 штук могут быть совершенно оригинальными, но при этом очень цепляющими. Например, с неожиданным использованием метафор, игрой слов или апелляцией к эмоциям, которых нет в эталоне. По BLEU они получат низкие баллы, и вы, полагаясь только на эту метрику, просто выбросите эти 20-30 гениальных вариантов. А ведь именно они могли бы принести те самые 80% конверсии, которые вы так ищете.

Это как пытаться оценить музыкальное произведение, просто сравнивая ноты с эталонной партитурой. Если исполнитель добавил свою интерпретацию, изменил темп, или даже импровизировал, BLEU (условно говоря) будет кричать о "несоответствии", хотя на самом деле это может быть шедевр. И мы, как мастера слова, не должны этого допускать.

Альтернативы BLEU: Инструменты для оценки неуловимого

Раз уж BLEU не справляется с креативными задачами, значит, нужны другие метрики. И они есть! Наша задача – выбрать те 20% инструментов, которые дадут 80% адекватной оценки для креативного контента.

1. TER (Translation Edit Rate): Точность, учитывающая правки.TER — это метрика, которая оценивает качество перевода, исходя из количества редакций (вставок, удалений, замен, перемещений слов), необходимых для превращения машинного перевода в эталонный. Чем меньше правок, тем выше качество. Чем она хороша для креативных задач? Тем, что она более гибка. Если ИИ сгенерировал фразу, которая семантически верна, но требует небольших изменений в порядке слов или замене одного синонима на другой для идеальной формулировки, TER это учтет. Она не обнуляет оценку за отсутствие точного совпадения, а показывает "расстояние" до идеала. Это позволяет нам оценить не просто совпадение слов, а редактируемость и потенциал креативного текста.

# Пример TER (псевдокод)

def calculate_ter(machine_output, reference):

# Логика расчета минимального количества редакций

# (вставки, удаления, замены, перемещения)

# для преобразования machine_output в reference

num_edits = min_edits_to_transform(machine_output, reference)

return num_edits / len(reference.split())

# Сценарий: ИИ сгенерировал слоган, близкий к эталону, но требующий небольшой правки.

# Эталон: "Купи сейчас, и получишь скидку!"

# МП: "Покупай сегодня, скидка будет твоя!"

# BLEU будет низким, TER покажет небольшое количество правок, что гораздо информативнее.

2. Человеческая оценка по шкале Лайкерта: Когда эксперт – главный судья.

Это, пожалуй, самый золотой стандарт для оценки креативного контента. Шкала Лайкерта позволяет экспертам (носителям языка, маркетологам, копирайтерам) оценить качество сгенерированного ИИ текста по нескольким параметрам: креативность, оригинальность, эмоциональный отклик, релевантность целевой аудитории, удобочитаемость. Оценка происходит по шкале, например, от 1 до 5 (где 1 – "абсолютно неприемлемо", а 5 – "отлично").

Это те самые 20% инвестиций в "человеческий фактор", которые приносят 80% реального понимания. Да, это дольше и дороже, чем автоматические метрики, но для креативных задач это безальтернативно. Выборка может быть небольшой – 50-100 примеров уже дадут отличную статистику. Главное – правильно составить опросник и выбрать квалифицированных оценщиков. Именно так вы сможете понять, действительно ли ваш ИИ-поэт пишет стихи, а не набор рифмованных слов.

3. BERTScore и другие эмбеддинговые метрики:

Мы уже упоминали BERTScore, но в контексте креатива её роль становится ещё более значимой. Поскольку она оценивает семантическое сходство, а не просто лексическое совпадение, она может уловить смысл и тонкость креативного текста, даже если слова сильно отличаются от эталона. Например, если ИИ вместо "яркого солнца" напишет "золотистый диск в небе", BERTScore, скорее всего, оценит это как высокое семантическое сходство, в отличие от BLEU. Это позволяет автоматизировать часть оценки, сохраняя фокус на смысл, а не на буквы.

Когда метрика BLEU бесполезна и какие альтернативы выбрать для креативных задач?: Практика и KPI

Итак, подведем итог, как это все применять на практике, чтобы ваши креативные ИИ-тексты попадали в цель и приносили реальные дивиденды.

| Креативная задача | Неэффективность BLEU | Рекомендуемые альтернативы и KPI | Почему так? |

|---|---|---|---|

| Генерация слоганов / рекламных текстов | Игнорирует креативность, эмоциональный отклик. | A/B тестирование (CTR, конверсия), человеческая оценка (креативность, призыв к действию, узнаваемость бренда). | Главный KPI – реальная эффективность в маркетинге, которую метрики не покажут. |

| Генерация поэзии / художественных текстов | Не улавливает метафоры, ритм, рифму, образность. | Человеческая оценка (эмоциональный отклик, художественная ценность, оригинальность). | Крайне субъективная область, требующая человеческого восприятия. |

| Генерация диалогов для чат-ботов | Не оценивает естественность, юмор, контекст беседы. | Человеческая оценка (адекватность ответа, естественность диалога, юмор), метрики вовлеченности (время сессии, количество реплик). | Критичен пользовательский опыт и способность бота поддерживать живую беседу. |

| Генерация названий продуктов / услуг | Не учитывает благозвучие, запоминаемость, уникальность. | Человеческая оценка (узнаваемость, позиционирование, благозвучие), фокус-группы, тесты на запоминаемость. | Название – это лицо продукта, оно должно "цеплять" и работать на маркетинг. |

Как видите, для креативных задач фокус смещается с "формальной правильности" на "эффективность и воздействие". И здесь 80% результата дают те 20% усилий, которые мы тратим на человеческую оценку, A/B тестирование и глубокий анализ поведенческих факторов. ИИ в этом случае – это не финальный автор, а мощный генератор идей, ваш креативный партнер. Он создаст тысячу вариантов, а вы, как мастер слова, выберете из них те 20%, которые приведут к 80% успеха.

Именно в этом гибридном подходе – сила современного SEO и контент-маркетинга. Не стоит ограничивать себя устаревшими метриками, когда ИИ уже шагнул далеко вперед. Используйте BLEU там, где она эффективна, но не бойтесь выходить за её рамки, когда речь идет о творчестве и создании по-настоящему выдающегося контента. Ведь в конечном итоге, именно такие тексты попадают в топ выдачи и надолго задерживаются в памяти пользователей. И именно об этом был весь наш разговор – как заставить 20% усилий приносить 80% результата, даже в самых нестандартных задачах.